任何一个函数都可以被一个两层的神经网络近似 –李宏毅

这是神经网络的基础,可以去逼近真实的函数,不过也终究不会超过真实的函数

http://neuralnetworksanddeeplearning.com/chap4.html

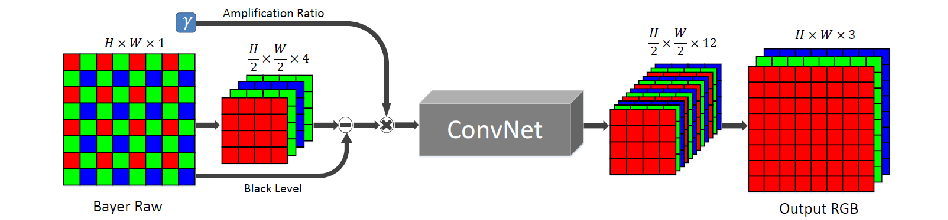

低照增强算法主要流程

最初的输入是曝光为10ms的raw图,最后的输出是曝光是1s的RGB图像,中间相差100倍的增益,因此中间会先给raw图一个100倍的增益

疑问:这样固定增益不会过曝么?

回答:因此后来这个增益是自适应的,raw图算出一个平均亮度,再从isp取一个目标亮度,算出一个倍数作为增益

疑问:如果去掉黑电平和增益会怎么样?

回答:如果包含了太多的操作,可能会导致函数不收敛,难训练

疑问:为什么深度学习不直接RAW to RAW,对RAW进行滤波和增强处理,再由ISP进行处理?

回答:ISP后续的gamma,降噪等模块可能会引入很多的噪声,和抹去很多的细节

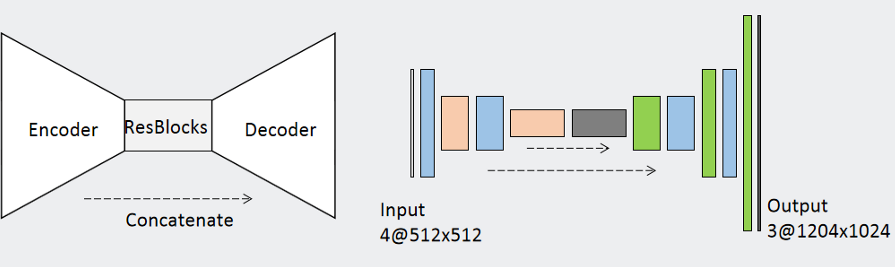

网络架构的设计

encoder是不断降采样的过程,减少运算,decoder是不断升采样的过程

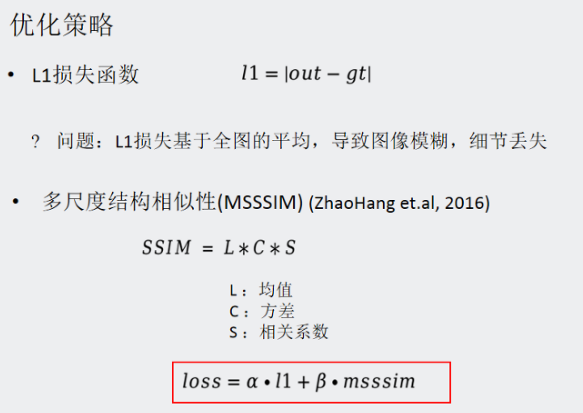

损失函数

就实验而言,L1>L2, L1就是一次方,求绝对值。L2就是平方差。L1可以防止不拟合,或者找的只是局部最优解

带来的问题,L1损失基于全图的平均,导致图像模糊,细节丢失。这个损失函数也就决定了这个模型训练出来的就类似一个低通滤波器

疑问:为什么不可以直接用统计值去训练,而不是直接用像素一一对应

回答:如果只需要统计值,那可以说是非监督训练,一般来说,非监督训练99.9%不如监督训练,能用监督训练,就尽量用监督训练